Die unterschiedlichen Ansätze der Künstlichen Intelligenz – Symbolic und Subsymbolic AI – stehen im Zentrum aktueller Diskussionen über Erklärbarkeit, Lernfähigkeit und Einsatzpotenzial intelligenter Systeme. In diesem Beitrag zeige ich dir, was die beiden Konzepte unterscheidet, wo ihre jeweiligen Stärken liegen und wie ein hybrider Ansatz die Zukunft intelligenter Systeme prägen kann.

Zentrale Punkte

- Symbolic AI nutzt explizite Regeln und ist besonders interpretierbar

- Subsymbolic AI setzt auf neuronale Netze und erkennt tiefe Muster

- Erklärbarkeit ist ein zentrales Unterscheidungskriterium

- Hybride Ansätze könnten beide Stärken sinnvoll kombinieren

- Datenbedarf unterscheidet die Systeme grundlegend

Wenn man tiefer in die Welt der Künstlichen Intelligenz einsteigt, zeigt sich schnell, dass viele dieser Systeme auf jahrzehntelanger Forschung beruhen. Symbolic AI war beispielsweise lange Zeit die dominante Strömung – man nannte sie auch „Good Old-Fashioned AI“. Hier ging es darum, menschenähnliches Denken mit formaler Logik zu simulieren und Expertenwissen in regelbasierte Strukturen zu überführen. Später kam mit den neuronalen Netzen und fortschrittlichen Lernalgorithmen die Subsymbolic AI hinzu, die sich stärker an biologischen Prozessen orientiert und über große Datenmengen trainiert wird. Heute liefert uns diese Kombination aus erklärbarer und lernfähiger Intelligenz ein Potenzial, das kaum zu überschätzen ist. Gleichzeitig offenbart sich ein Spannungsfeld bezüglich Erklärbarkeit, Transparenz und Vertrauen, das insbesondere in sicherheitskritischen Anwendungen immer wichtiger wird.

Symbolic AI: Logikbasierte Entscheidungsintelligenz

Symbolic AI orientiert sich an der menschlichen Fähigkeit zu argumentieren. Sie arbeitet mit klar definierten Symbolen, Regeln und logischen Schlussfolgerungen. Durch diese klare Struktur kann ich jederzeit nachvollziehen, wie eine bestimmte Entscheidung zustande gekommen ist. Für Anwendungen in der Medizin oder im Recht ist diese Eigenschaft entscheidend. Hier zählt Transparenz mehr als spontane Anpassungsfähigkeit.

Symbolic Systeme benötigen allerdings tiefes Vorwissen zur Problemumgebung. Fachleute müssen Regeln manuell definieren. Das ist aufwändig, erlaubt aber gleichzeitig eine sehr gezielte Steuerung des Verhaltens. In lösungsorientierten Auskunftssystemen auf Basis von Fallwissen spielt Symbolic AI eine zentrale Rolle.

In historischen Kontexten war Symbolic AI in Form von sogenannten Expertensystemen stark vertreten. Beispielsweise halfen medizinische Expertensysteme dabei, Diagnosevorschläge zu generieren, indem sie das Symptombild mit hinterlegtem Fachwissen abglichen. Expertensysteme konnten sogar neue Fälle kombinieren und teilweise recht präzise Empfehlungen abgeben. Problematisch wurde es in dem Moment, wo neue, unbekannte Fälle auftraten. Dann musste das System erst wieder von Experten um neue Regeln ergänzt werden, was sehr zeit- und ressourcenintensiv war. Dennoch ist es beeindruckend, wie gut sich regelbasierte Systeme für Domänen eignen, in denen ein begrenzter Satz an Regeln und Ausnahmen eindeutig definierbar ist.

Ein weiterer Vorteil von Symbolic AI liegt in seiner Fähigkeit, logisch zu argumentieren. Stell dir beispielsweise ein System vor, das bei einer Rechtsberatung prüft, welche Paragrafen und Gesetze für einen konkreten Fall relevant sind. Es kann die Zusammenhänge Schritt für Schritt darlegen, sodass für Anwenderinnen und Anwender transparent ist, warum eine Empfehlung zustande kommt. Gerade in sensiblen Bereichen wie Medizin, Recht oder Finanzentscheidungen entsteht so Vertrauen in ein KI-System.

Subsymbolic AI: Lernen aus Erfahrung

Im Gegensatz dazu basiert Subsymbolic AI auf neuronalen Netzen, die aus Daten lernen. Anstatt logische Regeln anzuwenden, erfassen sie statistische Muster. Dieser Ansatz folgt dem Vorbild des menschlichen Gehirns, das über Erfahrung lernt und sich anpasst. Ihre größte Stärke liegt in der Mustererkennung, etwa bei Bildern, Sprache oder Text.

Ein neuronales Netz muss nicht wissen, was eine „Katze“ ist – es erkennt sie zuverlässig, wenn es genügend Beispielbilder gesehen hat. Das macht Subsymbolic AI dynamisch und skalierbar. Doch mit dieser Flexibilität erkauft man sich einen großen Nachteil: Die internen Entscheidungswege bleiben undurchsichtig. Gerade in sicherheitskritischen Anwendungen ist diese geringe Erklärbarkeit problematisch.

Im Laufe der Zeit haben sich verschiedene Architekturen von neuronalen Netzen entwickelt: Von einfachen Feedforward-Netzen über Convolutional Neural Networks (CNNs) für die Objekterkennung bis hin zu Rekurrenten Netzen (RNNs) für die Sprachverarbeitung. In jüngster Zeit erleben wir mit den sogenannten Transformer-Architekturen einen weiteren Fortschritt, der vor allem im Bereich natürlicher Sprache zu enormen Leistungssteigerungen geführt hat. Dennoch bleibt der Grundsatz der „Black Box“ bestehen. Zwar gibt es Ansätze wie Layer-wise Relevance Propagation oder Class Activation Maps, um dem Netz sozusagen in die „Gedankenwelt“ zu schauen, doch wirklich verständlich wird der Entscheidungsprozesses nur selten.

Sinnbildlich dafür steht die Debatte um sogenanntes „Overfitting“: Das Netz kann sich zu stark an Trainingsdaten anpassen und dadurch mögliche Generalisierungen verlieren. In kritischen Bereichen – etwa bei medizinischen Diagnosen oder autonomen Fahrzeugen – ist es jedoch essenziell, dass ein KI-System nicht nur gut auf bekannten, sondern auch auf neuen, leicht veränderten Daten performant ist. Hier zeichnet sich die größte Herausforderung ab: Es braucht riesige Datenmengen, um ein neuronales Netz robust zu trainieren.

Direkter Vergleich der beiden KI-Ansätze

Damit du Unterschiede und Gemeinsamkeiten schnell erfassen kannst, habe ich sie dir hier gegenübergestellt:

| Merkmal | Symbolic AI | Subsymbolic AI |

|---|---|---|

| Wissensdarstellung | Explizite Regeln und Symbole | Implizite Muster im Netz |

| Lernweise | Manuelle Wissensmodellierung | Datenbasiertes Lernen |

| Erklärbarkeit | Sehr hoch | Begrenzt (Black Box) |

| Flexibilität | Gering | Sehr hoch |

| Datenbedarf | Gering | Hoch |

| Beispielanwendungen | Expertensysteme, Logik | Bilderkennung, Sprachmodellierung |

Historisch betrachtet waren die Ansätze sehr getrennt: Symbolic AI wurde in den 1970er und 1980er Jahren intensiv erforscht, während Subsymbolic AI ihren Durchbruch in den letzten Jahrzehnten vor allem dank größerer Rechenleistung erzielen konnte. Heutzutage verschmelzen die Methoden jedoch zunehmend, weil Forscherinnen und Forscher erkannt haben, dass beide Herangehensweisen komplementäre Eigenschaften besitzen. Symbolische Systeme sind stark in klaren, begründeten Aussagen, neuronale Netze dagegen in der automatischen Extraktion tief verborgener Muster.

Selbstverständlich hängt die Wahl der Methode stark von der Anwendungsdomäne ab. Herrscht ein stabiles Umfeld mit klaren Regeln vor, kann Symbolic AI die beste Wahl sein. In hochvariablen Umgebungen mit riesigen Datenströmen hingegen entfalten neuronale Netze ihr volles Potenzial. Eine Herausforderung bleibt, das „richtige“ Zusammenspiel beider Welten zu gestalten, damit man von beiden Seiten profitiert, ohne eine Seite zu vernachlässigen.

Typische Einsatzfelder beider KI-Formen

Je nach Anforderung bietet sich entweder Symbolic oder Subsymbolic AI an. Ich habe typische Einsatzszenarien zusammengefasst.

Symbolic AI:

- Rechtsberatung durch regelbasierte Expertensysteme

- Medizinische Diagnosesysteme mit nachvollziehbarer Logik

- Maschinelle Übersetzung mit klarer Grammatikstruktur

Subsymbolic AI:

- Visuelle Objekterkennung in Überwachungssystemen

- Spracherkennung und -generierung für Chatbots

- Automatisierte Prognosemodelle im Finanzsektor

Gerade im Zusammenhang mit neuronalen Netzarchitekturen zeigen sich Anwendungen der Subsymbolic AI besonders deutlich.

Ein Beispiel aus der Praxis: Im Finanzsektor nutzt man neuronale Netze, um Aktienkurse oder Kreditrisiken vorherzusagen. Die zugrunde liegenden Regeln sind jedoch kaum transparent für Außenstehende. Kommt es zu einer falschen Bewertung, ist häufig unklar, welcher Schritt in der Netztopologie dazu geführt hat. Das sorgt gelegentlich für Skepsis. Umgekehrt lassen sich regelbasierte Kreditvergabesysteme zwar gut nachvollziehen, doch sie berücksichtigen nicht immer alle Muster, die in großen Datenmengen auftreten könnten, und sind bei plötzlichen Marktveränderungen weniger flexibel. Genau hier könnte ein hybrider Ansatz ansetzen, der beides verknüpft.

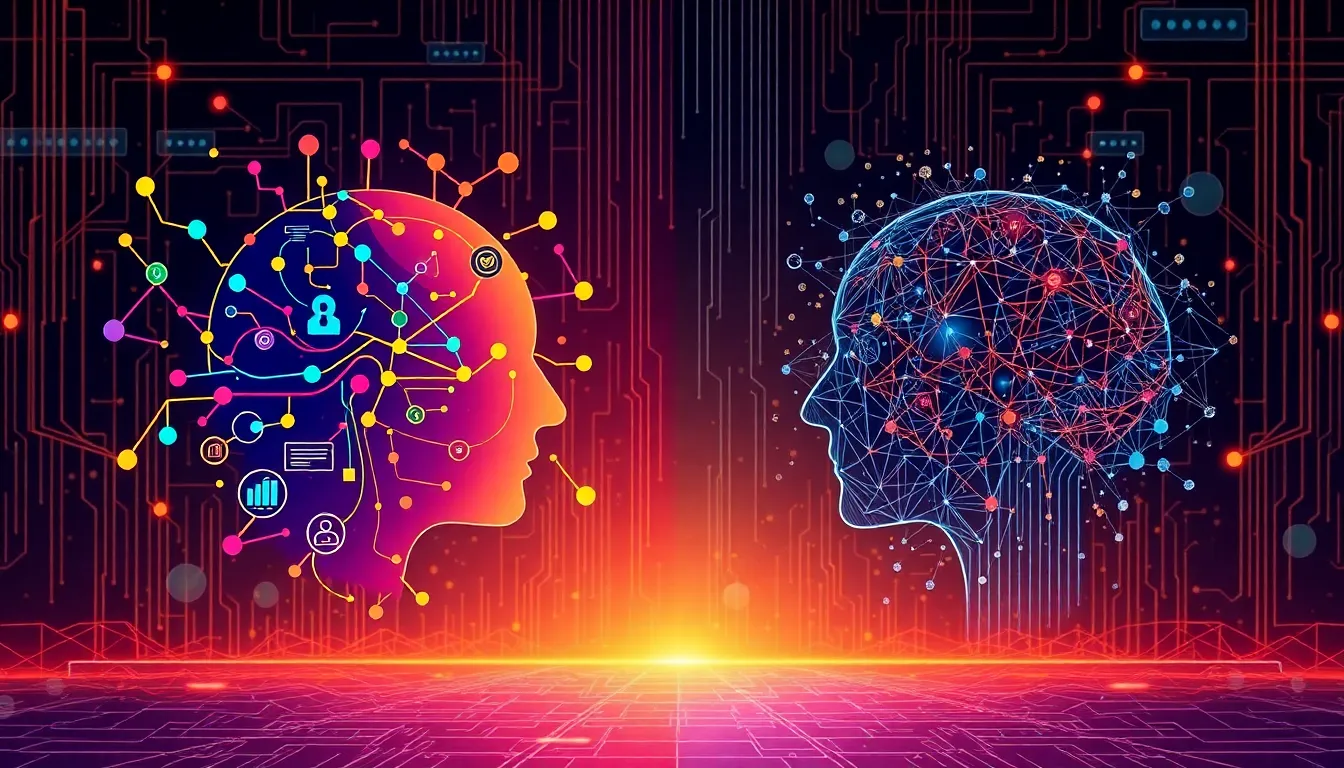

Warum nicht beides? Hybridmodelle im Aufschwung

Während Symbolic AI Erklärbarkeit und Struktur beisteuert, liefert Subsymbolic AI kreative Generalisierung aus Erfahrung. Doch was, wenn ich beides kombinieren möchte? Genau das versucht Intersymbolic AI. In einem solchen hybriden System kann zum Beispiel ein neuronales Netz visuelle Daten erkennen, während ein symbolisches Modul das Ergebnis logisch einordnet.

Denkbar ist auch die andersherum verlaufende Verschaltung: Ein symbolisches System identifiziert mögliche Lösungswege – ein neuronales Netz optimiert deren Ausführung. In der Praxis verbessert das nicht nur die Sicherheit des Gesamtsystems, sondern erlaubt auch dynamischere Anwendungen, beispielsweise im autonomen Fahren oder in industriellen Assistenzsystemen.

Hybride Ansätze greifen oft auf sogenannte symbolische Regeln für die Top-Level-Entscheidungen zurück, etwa um ethische Leitlinien oder regulatorische Vorschriften zu berücksichtigen. Ein neuronales Teilmodell kann dann für die Feinjustierung und Mustererkennung eingesetzt werden. So lässt sich beispielsweise in einem autonomen Fahrzeug ein symbolisches Modul etablieren, das Verkehrsregeln wie Geschwindigkeitsbegrenzungen, Vorfahrtsregeln und Sicherheitsabstände kennt, während ein neuronales Modul die Umgebung permanent scannt und flexibel auf unvorhergesehene Situationen reagiert. Zusammen entsteht eine KI, die im Idealfall rasch auf Veränderungen reagieren kann, ohne die Prinzipien, die wir als gesellschaftlich wichtig erachten, zu vernachlässigen.

Ein weiteres spannendes Forschungsfeld im Bereich der Hybridmodelle ist die sogenannte „Neuro-Symbolic Reasoning“. Hier versucht man, die Mustererkennungsfähigkeit neuronaler Netze mit der expliziten Symbol-Logik zu verbinden, um somit sowohl schnelle Generalisierungen als auch tiefe Erklärbarkeiten zu ermöglichen. Ein typischer Ansatz wäre, wenn das neuronale Netz ein Bild klassifiziert und daraufhin ein symbolisches Modul die Kontextinformationen – etwa über die Umgebung, in der das Objekt gefunden wurde – auswertet. So kann man zum Beispiel Fehldiagnosen oder falsche Zuordnungen reduzieren, weil das symbolische Modul auffällige Diskrepanzen erkennt.

Technologie, die denkt wie der Mensch

Hybride Modelle ahmen die Art und Weise nach, wie Menschen bewusstes Nachdenken mit instinkthaften Reaktionen kombinieren. Ich entscheide nicht nur logisch – oft treffe ich Entscheidungen „aus dem Bauch“, die aber durch Erfahrung geprägt sind. Genauso könnte eine Intersymbolic AI erst ein Bild klassifizieren, dann durch symbolische Vernunft den Kontext bewerten. Das eröffnet Chancen in der Embodied AI, wo Maschinen ihre Umgebung nicht nur wahrnehmen, sondern auch logisch darin handeln müssen.

In diesem Zusammenhang lohnt es sich, einen Blick auf die Entwicklung interaktiver Assistenzsysteme zu werfen. Stell dir vor, du hast einen Roboterassistenten in der Pflege, der Patienten durchs Krankenhaus begleitet. Das neuronale Netz erkennt Hindernisse, Menschen und Rollstühle, während ein symbolisches Modul prüft, ob bestimmte Sicherheitsvorschriften eingehalten werden oder ob der Roboter sich in einer Zone befindet, in der Zugänge aus Datenschutzgründen tabu sind. Durch diesen Mix hat man sowohl die Fähigkeit zur Echtzeitanpassung als auch ein hohes Maß an Nachvollziehbarkeit, warum bestimmte Entscheidungen – beispielsweise das Anhalten an Türen, die nur mit Berechtigungspassiercode geöffnet werden dürfen – getroffen wurden.

All das mündet in eine echte Mensch-Maschine-Kollaboration, in der Vertrauen und Verlässlichkeit Grundpfeiler sind. Menschen neigen dazu, Technik dann stärker zu nutzen, wenn sie ihre Funktionsweise und Grenzen verstehen. Ein hybrider Ansatz kann genau dieses Verständnis stützen.

Langfristige Perspektive beider Methoden

Die Zukunft der Künstlichen Intelligenz liegt nicht im Entweder-oder. Die Kombination aus formalisierter Logik und datenbasiertem Lernen schafft Systeme, die sicher, leistungsfähig und flexibel agieren. Während reine Subsymbolic AI auf Datenmenge und Rechenleistung angewiesen bleibt, kann die Integration symbolischer Strukturen zu sparsamen, zuverlässigeren Modellen führen.

In der Bildungs- oder Medizininformatik etwa, wo Verantwortung und Erklärbarkeit unerlässlich sind, entsteht so echtes Vertrauen in KI-basierte Entscheidungen. Gleichzeitig eröffnen sich wachstumsstarke Felder wie autonome Robotik, Sprachtechnologie und individuelle Assistenzsysteme, die stark von einem kombinierten Ansatz profitieren.

Gleichzeitig sollten wir im Blick behalten, dass der Übergang zu hybriden Systemen nicht trivial ist. Die Implementierung erfordert Know-how in beiden Disziplinen – Symbolic und Subsymbolic AI – und das Zusammenspiel muss sorgfältig aufeinander abgestimmt werden. Beispielsweise kann es notwendig sein, die Art und Weise, wie ein neuronales Netz trainiert wird, mit den vordefinierten Regeln abzugleichen. Ein weiteres Spannungsfeld könnten ethische und rechtliche Fragen sein: Welche Aspekte der Entscheidungslogik sind durch fest kodierte (symbolische) Regularien vorgegeben, und wo darf das System eigene Heuristiken oder Netzwerk-Weights anpassen?

Auch bei der Datenbeschaffung ergeben sich Unterschiede: Während symbolische Systeme in hohem Maße von Experteninterviews oder von Gesetzen, Vorschriften und Standard-Protokollen leben, sind neuronale Netze größtenteils von umfangreichen Trainingsdaten abhängig. Je nach Aufgabe braucht man also entweder viel Domänenwissen (symbolisch) oder riesige Datenbestände (subsymbolisch) – oder eben beides. Die Zukunft liegt vermutlich in einer guten Balance aus Datensätzen, die gezielt aufbereitet werden, sowie klar definierter symbolischer Regeln, welche die Netze effizienter und sicherer machen.

Gerade in hochdynamischen Bereichen wie dem autonomen Fahren, in dem höchste Sicherheitsstandards gelten, wird in Zukunft kein Weg an hybriden Ansätzen vorbeiführen. Hier ist es nicht nur wichtig, Objekte am Straßenrand oder andere Verkehrsteilnehmer korrekt zu erkennen, sondern auch regelkonform zu handeln und kritische Situationen exakt abzuwägen. Subsymbolic AI erfasst dabei die sensorischen Eindrücke in Echtzeit, Symbolic AI entscheidet über angemessene Reaktionen. Zudem kann dank Symbolic AI auch nachträglich überprüft werden, warum eine Bremsung erfolgt ist – was für die Unfallforschung und Vorgehensweisen bei Haftungsfragen essentiell sein kann.

In der medizinischen Diagnostik wiederum kann ein neuronales Netz Auffälligkeiten in Röntgen- oder MRT-Bildern erkennen, die ein symbolisches Modul basierend auf Krankheitsdatenbanken und Befunden bewertet. So ließen sich Fehldiagnosen reduzieren und die ärztliche Expertise gezielt unterstützen, statt sie zu ersetzen. Langfristig entsteht eine KI, die nicht nur Schwarz-Weiß-Aussagen über Pathologien trifft, sondern die Erkenntnisse so verknüpft, dass die behandelnde Person die Entscheidungen der KI nachvollziehen kann.

Zusammenfassung: Zwei Pfade, ein gemeinsames Ziel

Symbolic AI und Subsymbolic AI verfolgen unterschiedliche Denkmodelle: Regeln vs. Erfahrung, Logik vs. Intuition. Beide haben ihre Daseinsberechtigung – und ergänzen sich erstaunlich gut. Wo Regelbasierung an Grenzen stößt, glänzt das neuronale Lernen. Wo Black-Box-Modelle Transparenz vermissen lassen, schafft Symbolik Orientierung.

Die intelligente Technik von morgen wird beides beherrschen müssen. Intersymbolic AI ist keine theoretische Vision mehr, sondern steht bereits in praktischer Forschung und ersten Anwendungen. Ob in autonomer Technik, bildgebender Diagnostik oder der Interaktion mit Menschen – hybride Intelligenz bietet mehr als die Summe ihrer Teile.

Deshalb lohnt es sich auch künftig, beide Perspektiven im Blick zu behalten – gerade wenn es darum geht, Vertrauen, Genauigkeit und Lernfähigkeit in KI-Systemen miteinander zu verbinden. Auf lange Sicht ist es genau diese Vielfältigkeit, welche zum entscheidenden Wettbewerbsvorteil moderner KI-Lösungen wird. Unternehmen, Forschungseinrichtungen und Politik sind daher gut beraten, Symbolic und Subsymbolic AI nicht als konkurrierende, sondern als komplementäre Methoden zu verstehen, die gemeinsam die Innovationskraft der Künstlichen Intelligenz weiter vorantreiben.